ollama

Ollama 是一款开源跨平台大模型(LLM)工具,于 2023 年 7 月 9 日在 GitHub 上线,它提供了简洁易用的命令行界面和服务器,使用户能够轻松下载、运行和管理各种开源 LLM,通过 Ollama,用户可以方便地加载和使用各种预训练的语言模型,支持文本生成、翻译、代码编写、问答等多种自然语言处理任务。

官方网址:https://ollama.com/

特点

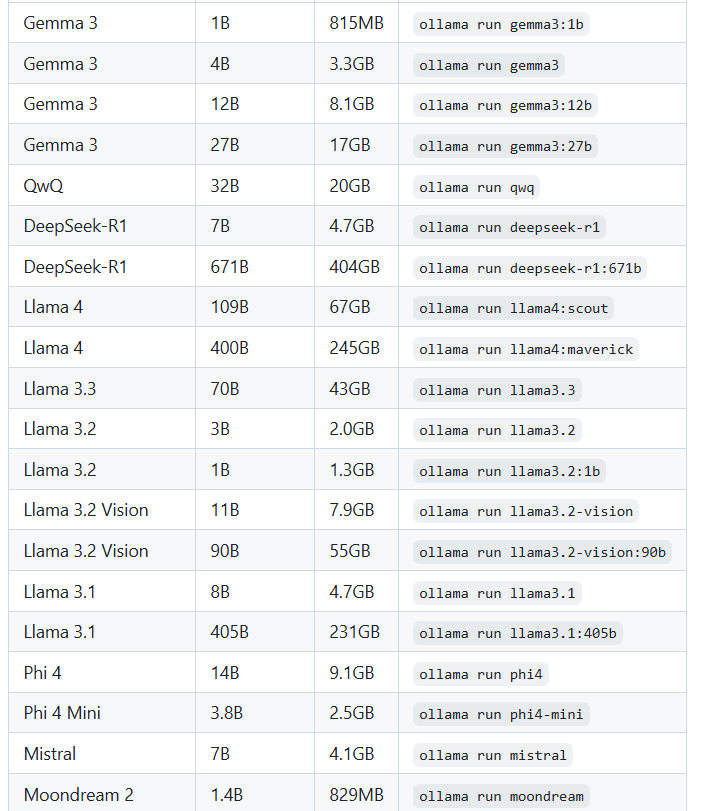

多种模型支持:可使用 Qwen、Llama、DeepSeek - R1、Llama 3.3、Phi - 4、Mistral、Gemma 2 等 30 多种先进的语言模型,用户能根据需求加载不同模型,无需局限于单一模型。

易于集成和使用:提供命令行工具和 Python、JavaScript SDK,简化与其他项目和服务的集成。通过几条命令即可完成安装和模型运行,无需复杂配置,适合新手和专业用户。

支持多平台:全面支持 Windows、macOS 和 Linux 系统,并提供 Docker 镜像,还能在不同操作系统上智能动态调配硬件资源。

数据隐私保护:允许在本地计算环境中运行模型,脱离对外部服务器的依赖,保证数据隐私,对于高并发请求,离线部署能提供更低延迟和更高可控性。

模型可微调与自定义:用户不仅可使用预训练模型,还可在此基础上进行模型微调。开源架构也支持用户自定义模型,社区还会持续更新前沿技术与应用方案。

资源高效利用:采用 4 - bit 量化技术显著降低显存需求,能在消费级显卡上运行 70B 参数模型,在处理大规模数据时依然保持高效。

ollama下载安装

Linux环境为例

https://github.com/ollama/ollama

https://github.com/ollama/ollama/releases

环境准备

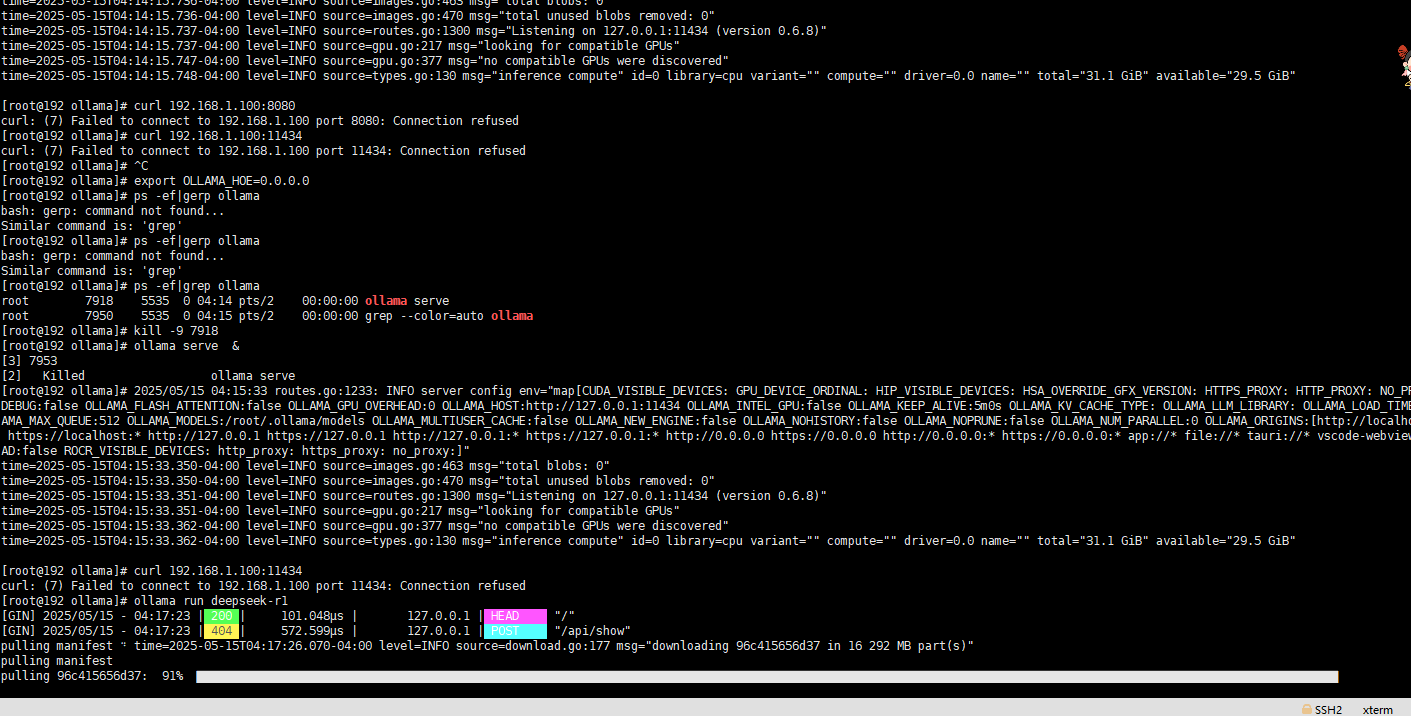

Centos8环境

curl -fsSL https://ollama.com/install.sh | sh或者

wget https://github.com/ollama/ollama/releases/download/v0.6.8/ollama-linux-amd64.tgz

tar -zxcf ollama-linux-amd64.tgz启动ollama服务

ollama serve & 启用大模型

ollama run deepseek-r1https://github.com/ollama/ollama